Entry #1 15.9.2021

Künstliche Intelligenz und Prognosen

Christophe Rippinger

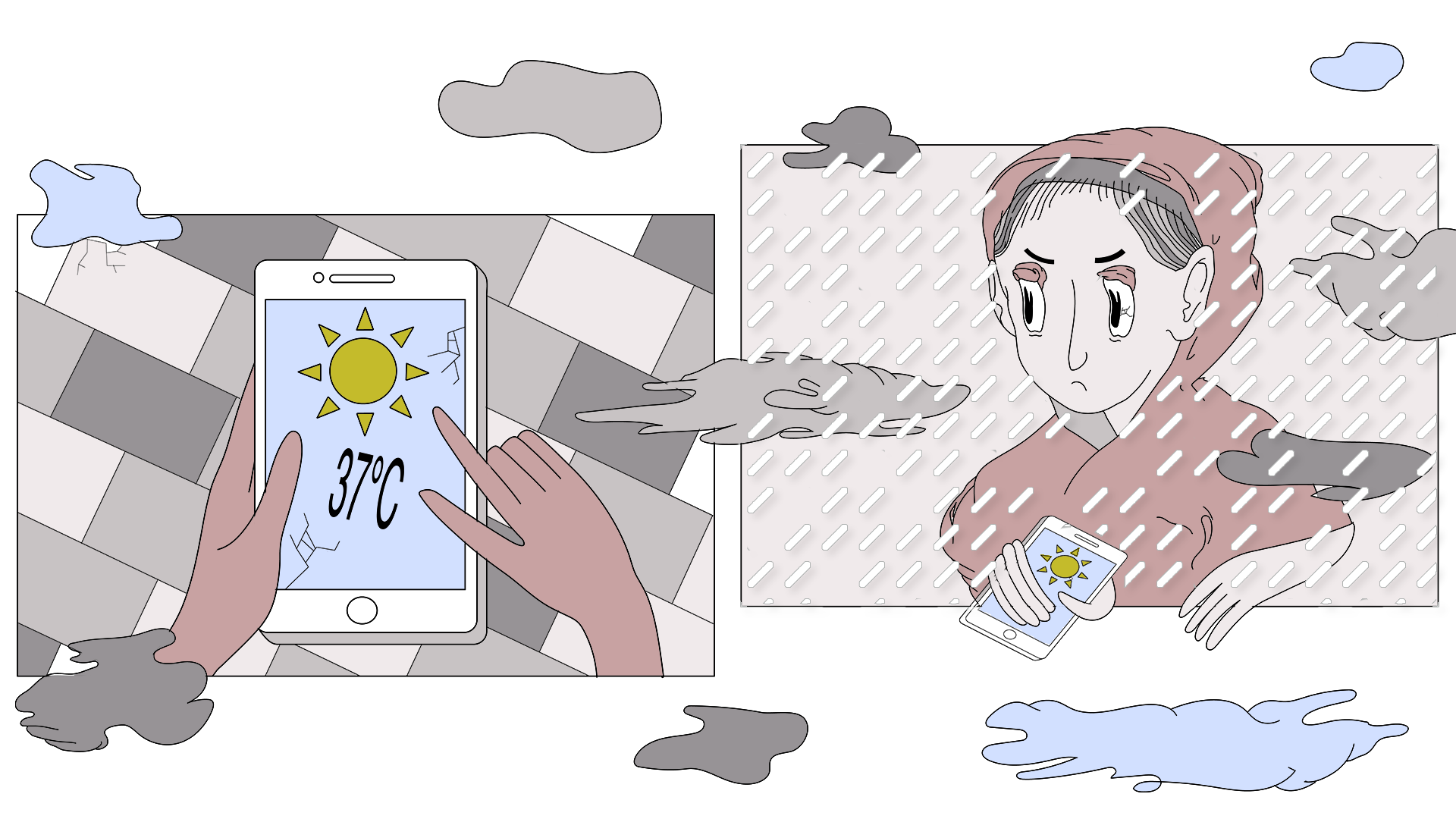

Illustration by Lynn Klemmer

Der Soziologe Jens Beckert analysiert in Imaginierte Zukunft – Fiktionale Erwartungen und die Dynamik des Kapitalismus den fiktiven Charakter von Werten in der Welt der Wirtschaft und die Wirkungskraft wirtschaftlicher Narrative. Der Blick von Wirtschaftsakteuren ist dabei in die Zukunft gerichtet, Handlungen in der Gegenwart orientieren sich an Erwartungen an die Zukunft. Um das zu ermöglichen, schafft die Wirtschaftstheorie sich eine strukturierende Umgebung in der Form von Narrativen. Mit ökonomischen Grundsätzen, Kausalitätszusammenhängen und Marktgesetzen generiert sie den Wirtschaftsakteuren eine beobachtbare Umwelt, in der sie sich zurechtfinden können. Voraussetzung, dass diese geschaffene Parallelwelt Wirkungsmacht erhält, ist ein ausreichendes Maß an Gläubigern. Der Wert eines Unternehmens lässt sich nur steigern, wenn es genügend Akteure gibt, die diese Annahme teilen. Der Wert eines Objektes ist nicht intrinsisch gegeben, es muss auch jemand bereit sein, den geforderten Preis zu bezahlen. Ein Aktienkurs verläuft nicht nach oben, wenn die Anleger mit dem Konkurs dieses Unternehmens ausgehen. Die Instrumente und Variablen der Theorien der Wirtschaftswissenschaftler sind begrenzt und unvermeidbar unvollständig. Zu viele Faktoren müssten berücksichtigt werden, um ein realistisches Abbild des Wirtschaftsraums zu generieren. Die Prognosen der Wirtschaftswissenschaftler ähneln dadurch einem Blick in eine Kristallkugel, wodurch ein performatives Wunschbild erzeugt wird. Das bedeutet, die Akteure beobachten vor allem das, was die Theorie verspricht, vorausgesetzt, dass genügend Akteure der Theorie entsprechend handeln. Die Gerüchte über den Konkurs eines Unternehmens können dann dazu führen, dass die Aktionäre ihre Anteile aus Verlustängsten verkaufen. Am Ende kann das Unternehmen tatsächlich in den Ruin getrieben werden, obwohl das Gerücht überhaupt keinen Wahrheitsgehalt besitzt.

Der Eintritt der KI in die Welt der Prognosen

In vielen Bereichen der Gesellschaft wird bereits auf KI zurückgegriffen, so auch in der Wirtschaft, speziell auf dem Aktienmarkt. Sind Algorithmen in der Lage, weitere Variablen und Gesetzmäßigkeiten zu erkennen und in Modelle zu integrieren, die eine genauere Prognose ermöglichen, die über eine bloße Projektion der Vergangenheit in die Zukunft herausgeht? Anders gefragt: Macht die KI die Zukunft ein Stückweit lesbarer?

Um sich dieser Frage anzunähern, muss man zuerst verstehen, wie ein Algorithmus funktioniert. Dabei handelt es sich um nichts anderes als eine Programmierung, ein Rezept, das Maschinen anwenden. Rechner setzen ohne zu hinterfragen um, was die Programmierer in den jeweiligen Fällen vorschreiben. Kontrolle und Steuerung obliegen also nicht mehr direkt beim Programmierer, sondern es ist der Computer selbst, der zwischen Alternativen entscheiden muss. Diese Entscheidung ist jedoch nicht frei, der Rechner weiß genau, wie er sich in welchem Fall zu entscheiden hat. Die Maschine bleibt dabei abhängig von der Zufuhr von Daten und der Vorgabe der Handhabung dieser Daten. Lässt sich mit diesem Vorgehen, abgesehen vom Zeitgewinn, ein zusätzliches Output gewinnen? Ein besseres Verständnis der Wirtschaftszusammenhänge oder des Marktes lassen sich auf den ersten Blick nicht erreichen. Auch bei einem größeren Datenvolumen lässt sich die Erkenntnis nicht wirklich steigern, es ermöglicht höchstens zusätzliche Spielereien und das Erstellen von weiteren Modellen. Es gelingt auch immer wieder, ein Modell zu entwickeln, das richtige Prognose liefert. Aber wenn man 1000 Modelle generiert, und nur eines bewahrheitet sich, baut man dann nicht eine babylonische Bibliothek, in der man lediglich genug Modelle erschaffen muss, damit die Welt vorhersagbar wird?

Selbstlernende Systeme

Interessant könnte es jedoch werden, wenn selbstlernende Systeme zur Anwendung kommen. Dazu muss man den Unterschied zwischen den klassischen Algorithmen und selbstlernenden Programmen verstehen. Während Algorithmen dem Top-Down-Ansatz folgend vorprogrammierten Befehlen gehorchen, und damit in einer vorstrukturierten Umgebung operieren, verfügen selbstlernende Systeme über keinen menschlichen Input in struktureller Hinsicht, sie funktionieren nach dem Bottom-Up-Prinzip, das System erhält dadurch die Möglichkeit, seine Intelligenz selbst zu entwickeln. Zusammenhänge müssen somit von der Maschine selbst erkannt werden. Eben durch dieses experimentelle Lernen erhält die Maschine die Möglichkeit, eigene Wege der sinnbildenden Zusammenhänge zu gehen. Und diese Wege entziehen sich einer direkten Beobachtung des Menschen. DeepMind’s Alpha Go Zero dient dabei als anschauliches Beispiel. Der einzige menschliche Input bestand aus dem Regelwerk des Spiels. Im Anschluss hat das System in kürzester Zeit Millionen Partien gegen sich selbst gespielt und dabei eigene Taktiken entwickelt, die es am erfolgversprechendsten einstufte. Das Resultat ist bekannt, der Weltranglistenerste musste sich der Maschine geschlagen geben. Das Bitterste daran: Niemand kennt die Überlegungen, die Vorgehensweise von Alpha Go Zero. Die Strategie des maschinellen Systems wurde im Anschluss zwar von Spielern imitiert, die Begründung, das Verstehen, warum die KI diesen Zug machte, darüber muss der Mensch sich selbst Gedanken machen.

Wenn es hinter einer Strategie einer Maschine so etwas wie eine Überlegung oder Absicht (oder wie auch immer man eine solche Tatsache nennen soll) geben sollte, ist es denkbar, dass dies in einer Art und Weise passiert, die sich grundlegend von der Funktionsweise des menschlichen Bewusstseins unterscheidet. Wir können dies auch so deuten, dass hier zwei verschiedenartige Intelligenzen am Werk sind, die zwar Ähnliches leisten können, untereinander aber inkompatibel sind. Um die Vorgehensweise einer maschinellen selbstlernenden Intelligenz nachvollziehen zu können, braucht es womöglich eine Intelligenz der gleichen Art. Ein weiteres maschinelles System, das für dieselbe Aufgabe eine andere Strategie entwickeln würde, könnte einen komplett anderen Ansatz verfolgen. Bei Duellen würden beide voneinander lernen, und das erheblich schneller, als es bei einem Duell zwischen Mensch und Maschine der Fall ist. Die Duelle von maschinellen Intelligenzen würden auf einer Ebene stattfinden, die höchstwahrscheinlich die Kapazitäten der Nachvollziehbarkeit des menschlichen Gehirns übersteigt.

Prognosefähigkeit von maschinellen Systemen

Noch ist nicht absehbar, zu was eine selbstlernende KI alles fähig sein kann. Nicht alle Phänomene sind so leicht zu codieren wie das Regelwerk eines Brettspiels. Der Fakt, dass diese Systeme jedoch in der Lage sind, Strategien zu entwickeln, die sich der Nachvollziehbarkeit des Menschen entziehen, eröffnet freilich Möglichkeiten, an die man womöglich noch nicht denkt, oder gar nicht denken kann. Ein selbstlernendes System, das über die gleiche Sensibilität für Information wie der Mensch verfügt, würde in einer anderen Logik und mit einer anderen Systematik operieren, wie dies beim Menschen der Fall ist. Es ist denkbar, dass ein solches System Zusammenhänge erkennt, die aus menschlicher Perspektive überhaupt keinen Sinn ergeben, auch wenn es sich dabei um beobachtbare Tatsachen handelt. Und vielleicht wird ein selbstlernendes System eine Strategie entwickeln können, die Prognosen zuverlässiger gestalten kann, ob nun für die Wirtschaft, oder eine sonstige Domäne. Eine KI, die sich nach dem Bottom-Up-Ansatz entwickelt, operiert vielleicht sogar nach Prinzipien, für die es nach menschlichem Verfahren überhaupt keine Begriffe gibt.

Nehmen wir an, selbstlernende Maschinen können ohne die Kontrolle von Menschen operieren. Das heißt sie arbeiten, ohne dass diese Aktivität von Menschen gesteuert wird. Weiterhin nehmen wir an, dass Maschinen über immer mehr Daten verfügen, die sie für ihre Operationen heranziehen können. Und die Muster und Zusammenhänge, die diese KI erkennen kann, ermöglicht es ihr, genauere Aussagen über die Zukunft zu tätigen (denken wir beispielsweise an die an die Frau gerichtete Werbung für schwangere Frauen, bevor diese überhaupt weiß, dass sie schwanger ist). Das würde zwar nicht bedeuten, dass die Maschinen die Zukunft beherrschen, aber zumindest würde es ihnen ermöglichen, die Kontrolle über das Wissen zukünftiger Ereignisse zu erlangen. Möglicherweise stellen die selbstlernenden Systeme gar den Nährboden für eine starke KI dar. Und was eine starke KI mit der Zukunft anstellen könnte, kann wohl selbst eine selbstlernende schwache KI nicht vorhersehen. ︎

Christophe Rippinger, co-founder of Mnemozine, studies sociology at FernUni Hagen and is a writer and teacher. His latest novel, titled “Die Grenzen der Zeit : Die Zeit der Grenzen”, was self-published in 2021.

Baecker, D. (2019) Intelligenz, künstlich und komplex. Leipzig: Merve Verlag.

Beckert, J. (2018) Imaginierte Zukunft – Fiktionale Erwartungen und die Dynamik des Kapitalismus. Berlin: Suhrkamp Verlag.

“Künstliche Intelligenz: AlphaGo besiegt sich selbst.” Spektrum. 15.12. 2017. https://www.spektrum.de/magazin/alphago-besiegt-sich-selbst/1521035

“Künstliche Intelligenz: Die Macht der Algorithmen.” Handelsblatt. 16.08.2018. https://www.handelsblatt.com/technik/forschung-innovation/kuenstliche-intelligenz-die-macht-der-algorithmen/22913114.html?ticket=ST-1570130-tzXQY7Xs0MfrkPX5zGu9-ap3